機器之心報導編輯:杜偉今天凌晨,OpenAI的新系列模型GPT-4.1如約而至。

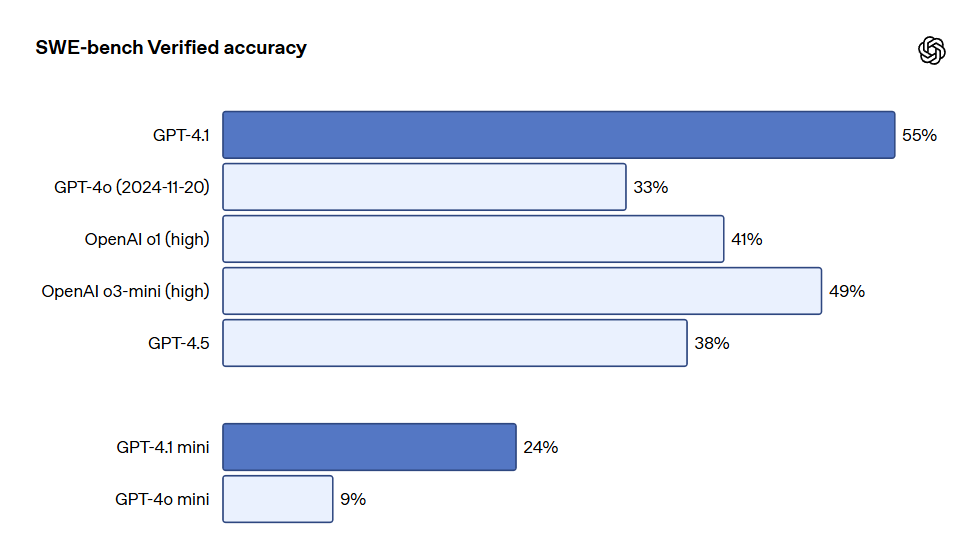

該系列包含三個模型,分別是GPT-4.1、GPT-4.1 mini和GPT-4.1 nano,這些模型僅通過API調用,並已向所有開發者開放。隨著該系列模型在多個關鍵功能上提供類似或更強的性能,並且成本和延遲更低,因此OpenAI將開始在API中棄用GPT-4.5預覽版。棄用時間為三個月後(2025年7月14日),以便為開發者提供過渡的時間。OpenAI表示,這三個模型的性能全面超越了GPT-4o和GPT-4o mini,在編程和指令遵循方面均有顯著提升。它們還擁有更大的上下文窗口——支持高達100萬個上下文token,並且能夠通過改進的長上下文理解更好地利用這些上下文。知識截止日期已更新至2024年6月。總的來說,GPT-4.1在以下行業標準指標上表現出色:編程:GPT-4.1在SWE-bench Verified測試中得分為54.6%,比GPT-4o提升21.4%,比GPT-4.5提升26.6%,使其成為領先的編程模型。指令遵循:在Scale的MultiChallenge基準測試(衡量指令遵循能力的指標)中,GPT-4.1得分為38.3%,比GPT-4o提升了10.5%。長上下文:在多模態長上下文理解基準測試Video-MME中,GPT-4.1創下了新的最高紀錄——在長篇無字幕測試中得分為72.0%,比GPT-4o提升了6.7%。

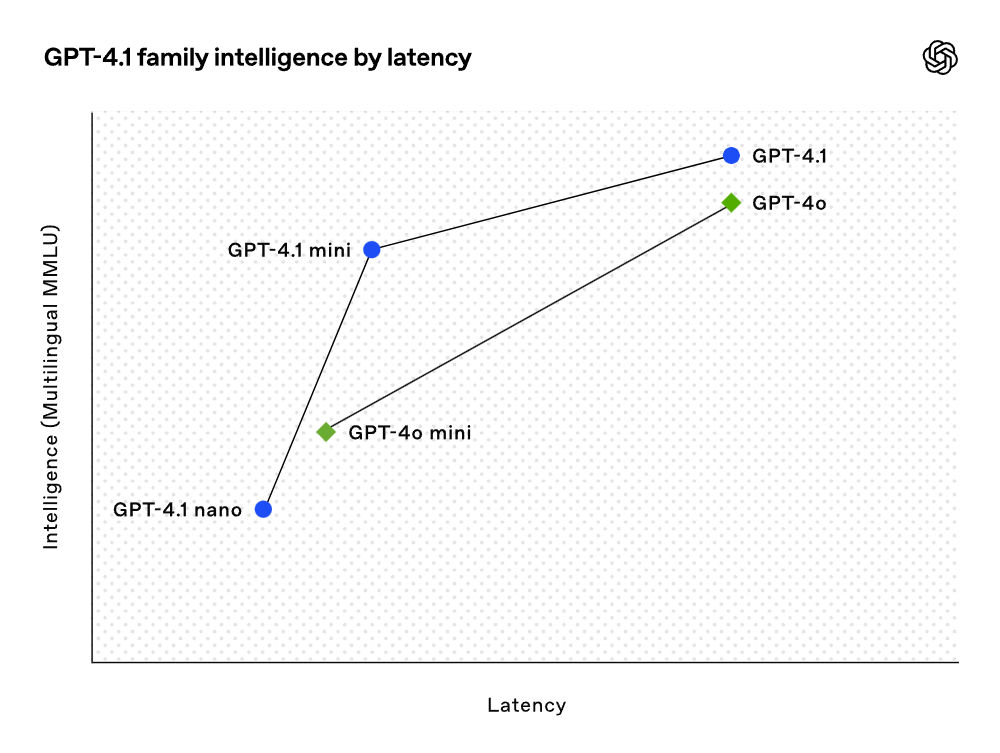

雖然基準測試成績相當不錯,但OpenAI在訓練這些模型時,重點關注了實際效用。通過與開發者社區的密切合作和夥伴關係,OpenAI針對開發者應用最相關的任務進行了優化,以使這些模型提供卓越的性能。這些模型在延遲曲線的每個點上都實現了性能的提升。

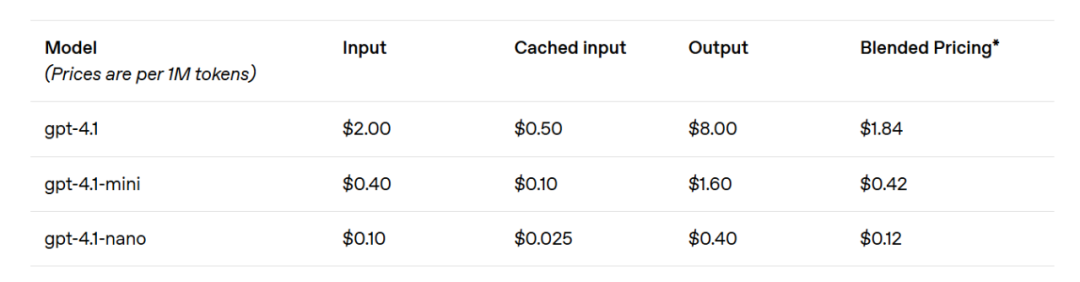

GPT-4.1 mini在小型模型性能上實現了顯著飛躍,甚至在多項基準測試中超越了GPT-4o。該模型在智能評估方面與GPT-4o平起平坐,甚至超越,同時將延遲降低了近一半,成本降低了83%。對於要求低延遲的任務,GPT-4.1 nano是OpenAI目前速度最快、成本最低的模型。該模型擁有100萬token上下文窗口,在小規模下仍能提供卓越的性能,且在MMLU測試中得分達80.1%、在GPQA測試中得分達50.3%、在Aider多語言編碼測試中得分達9.8%,甚至高於GPT-4o mini。該模型是分類或自動補全等任務的理想選擇。在指令遵循可靠性和長上下文理解方面的改進,也使GPT-4.1模型在驅動智能體(即能夠代表用戶獨立完成任務的系統)方面更加高效。結合Responses API等原語,開發者現在可以構建在實際軟體工程中更有用、更可靠的智能體,從大型文檔中提取洞見,以最少的手動操作解決客戶請求,以及執行其他複雜任務。同時,通過提升推理系統的效率,OpenAI得以降低GPT-4.1系列的價格。GPT-4.1的中等規模查詢成本比GPT-4o低26%,而GPT-4.1 nano是OpenAI至今為止最便宜、速度最快的模型。對於重複傳遞相同上下文的查詢,OpenAI將新系列模型的即時緩存折扣從之前的50%提升至75%。此外,除了標準的每token成本外,OpenAI還提供長上下文請求,且無需額外付費。

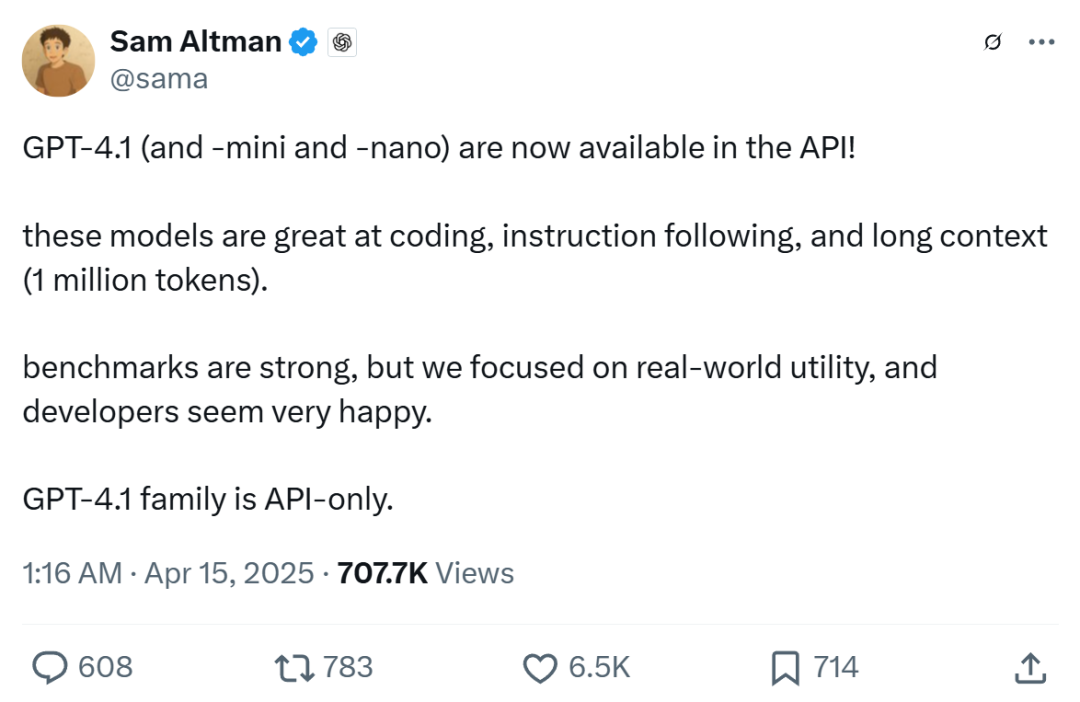

OpenAI CEO 山姆·奧特曼表示,GPT-4.1不僅在基準測試中表現優異,還專注於真實世界的實用性,應該會令開發者感到高興。

看來,OpenAI實現了自家模型能力上的「4.10﹥4.5」。

圖源:https://x.com/stevenheidel/status/1911833398588719274。編程GPT-4.1在各種編碼任務上都顯著優於GPT-4o,包括智能體解決編碼任務、前端編程、減少無關編輯、可靠遵循diff格式、確保工具使用一致性等任務。在衡量真實世界軟體工程技能的SWE-bench Verified測試中,GPT-4.1完成了54.6%的任務,而GPT-4o(2024-11-20)完成了33.2%。這反映了該模型在探索代碼庫、完成任務以及生成可運行和通過測試的代碼方面的能力提升。

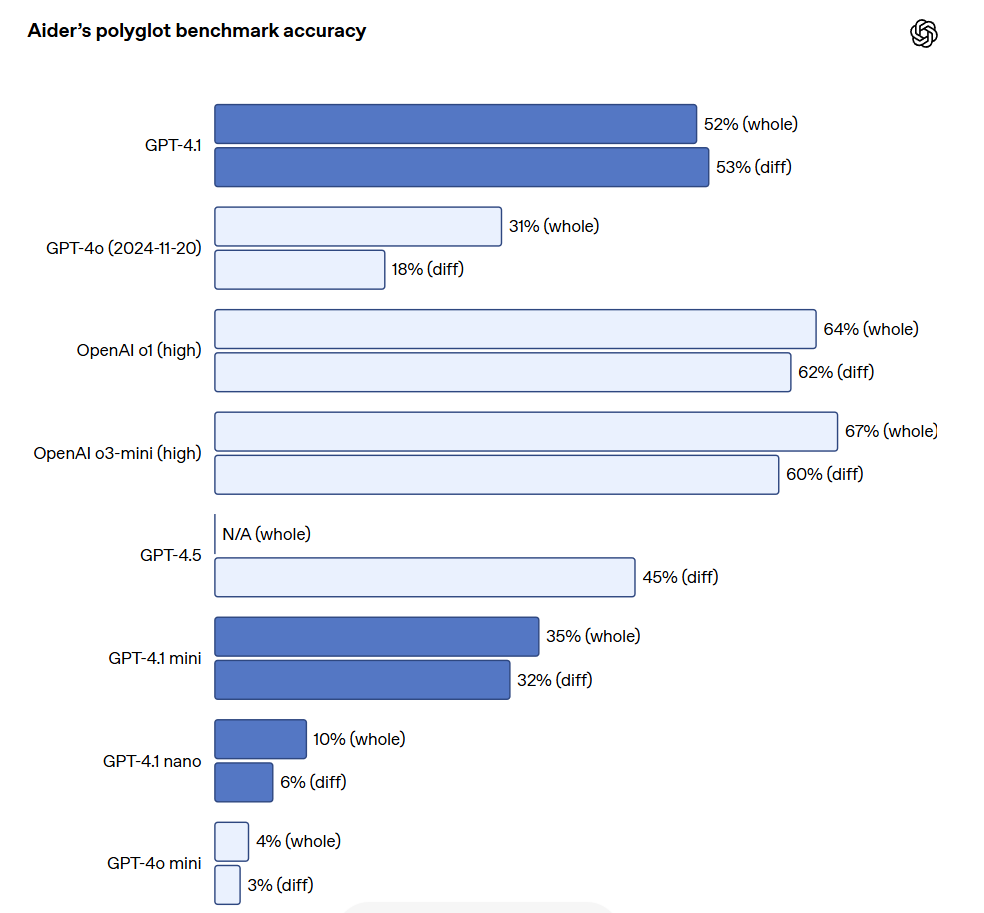

對於需要編輯大型文件的API開發者來說,GPT-4.1在處理各種格式的代碼diff時更可靠。在Aider的多語言差異基準測試中,GPT-4.1的得分是GPT-4o的兩倍多,甚至比GPT-4.5高出8%。這項評估既衡量了跨多種編程語言的編碼能力,也衡量了模型在整體和diff格式下生成更改的能力。OpenAI專門訓練了GPT-4.1,使其能夠更可靠地遵循diff格式,這使得開發者只需輸出更改的行,而無需重寫整個文件,從而節省成本和延遲。同時,對於喜歡重寫整個文件的開發者,OpenAI將GPT-4.1的輸出token限制增加到32,768個token(高於GPT-4o的16,384個token)。OpenAI還建議使用預測輸出来減少完整文件重寫的延遲。

GPT-4.1在前端編程方面也較GPT-4o有了顯著提升,能夠創建功能更加強大、更美觀的Web應用。在head-to-head對比中,付費人工評分員80%的評分結果顯示,GPT-4.1的網站比GPT-4o的網站更受歡迎。

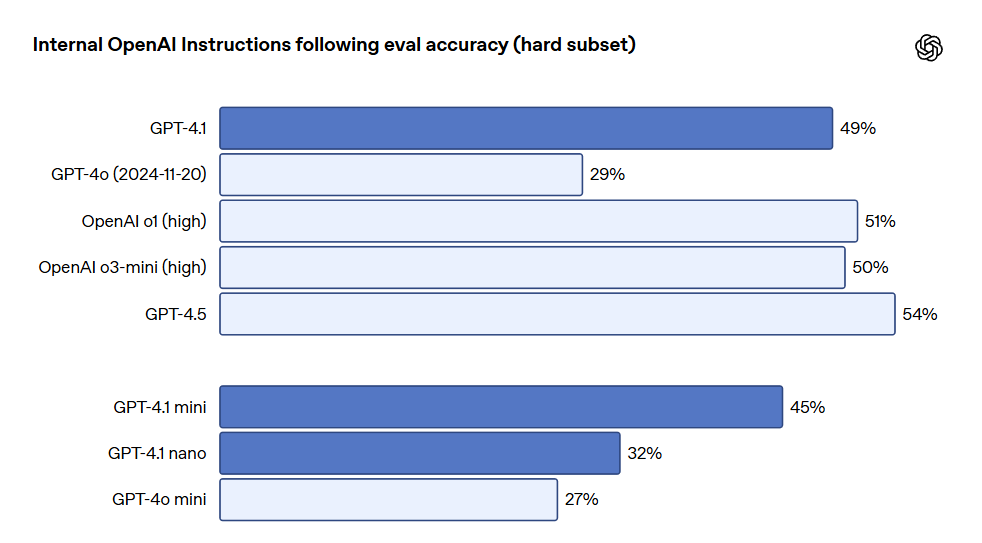

除了上述基準測試之外,GPT-4.1在遵循格式方面表現更佳,可靠性更高,並且減少了無關編輯的頻率。在OpenAI內部評估中,代碼中的無關編輯從GPT-4o的9%下降到了GPT-4.1的2%。指令遵循GPT-4.1能夠更可靠地遵循指令,並在各種指令遵循評估中實現了顯著的改進。OpenAI開發了一個內部指令遵循評估系統,用於跟踪模型在多個維度和幾個關鍵指令執行類別中的表現,包括:格式遵循。提供指令,指定模型響應的自定義格式,例如XML、YAML、Markdown等。負面指令。指定模型應避免的行為,例如:「不要要求用戶聯繫支持人員」。有序指令。提供一組模型必須按給定順序遵循的指令,例如:「首先詢問用戶的姓名,然後詢問他們的電子郵件地址」。內容要求。輸出包含特定信息的內容,例如:「編寫營養計劃時,務必包含蛋白質含量」。排序。以特定方式對輸出進行排序,例如:「按人口數量對響應進行排序」。過度自信。指示模型在請求的信息不可用或請求不屬於給定類別時回答「我不知道」或類似的內容,例如:「如果您不知道答案,請提供支持聯繫電子郵件地址」。這些類別是根據開發者的反饋得出的,表明了哪些指令遵循對他們來說最相關且最重要。在每個類別中,OpenAI將其分為簡單、中等和困難提示。GPT-4.1在困難提示方面的表現尤其優於GPT-4o。

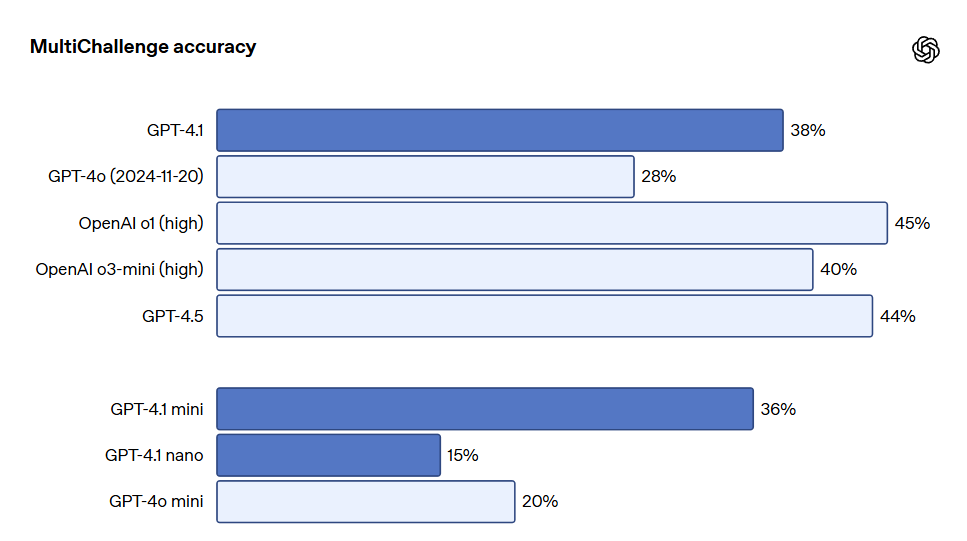

多輪指令遵循對許多開發者來說至關重要。對於模型來說,在對話中保持連貫性並跟踪用戶之前輸入的內容至關重要。GPT-4.1能夠更好地從對話中的過往消息中識別信息,從而實現更自然的對話。Scale的MultiChallenge基準測試是衡量這一能力的有效指標,GPT-4.1的表現比GPT-4o提高了10.5%。

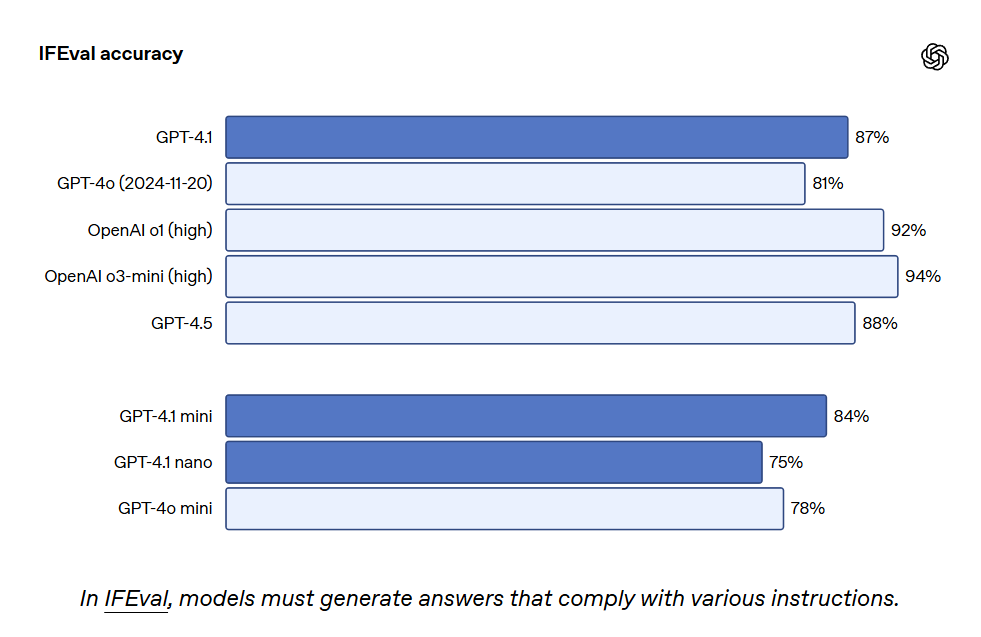

GPT-4.1在IFEval上也得到了87.4%,而GPT-4o的得分為81.0%。IFEval使用帶有可驗證指令的提示,例如指定內容長度或避免使用某些術語或格式。

更佳的指令遵循能力使現有應用程序更加可靠,並支持此前受可靠性低下限制的新應用程序。早期測試人員指出,GPT-4.1可以更加直觀,因此OpenAI建議在提示中更加明確和具體。長上下文GPT-4.1、GPT-4.1 mini和GPT-4.1 nano最多可處理100萬個上下文token,而之前的GPT-4o模型最多可處理12.8萬個。100萬個token相當於8個完整的React代碼庫,因此長上下文非常適合處理大型代碼庫或大量長文檔。GPT-4.1能夠可靠地處理100萬token上下文長度的信息,並在注意相關文本和忽略長短上下文干擾項方面比GPT-4o更加可靠。長上下文理解是法律、編程、客戶支持以及許多其他領域應用的關鍵能力。

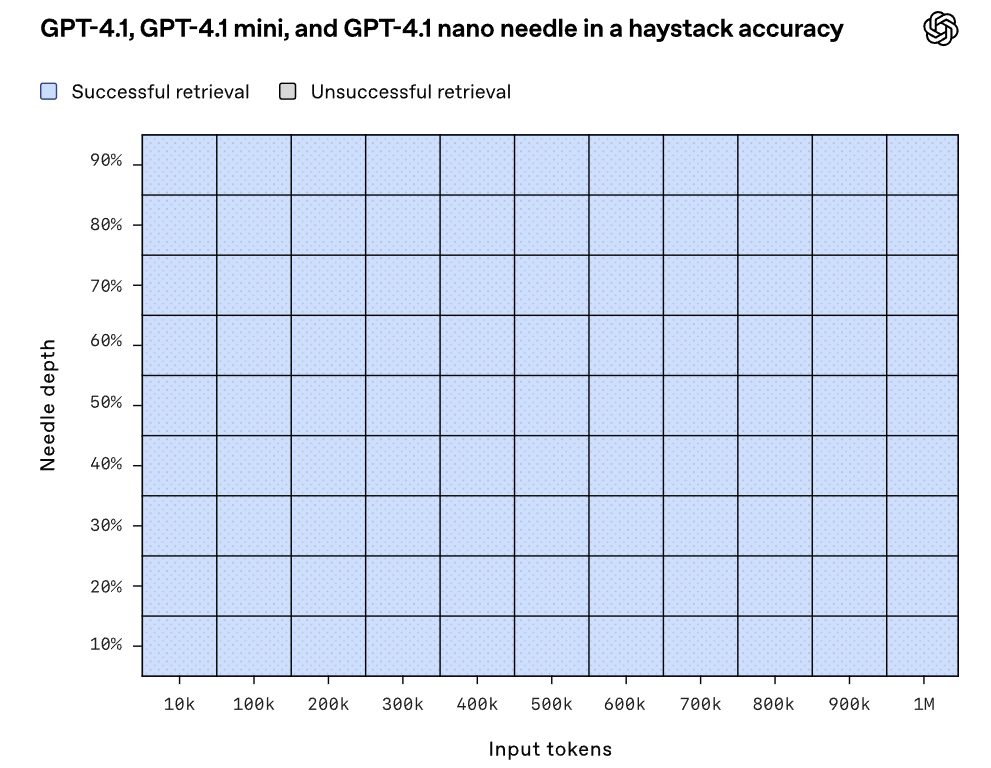

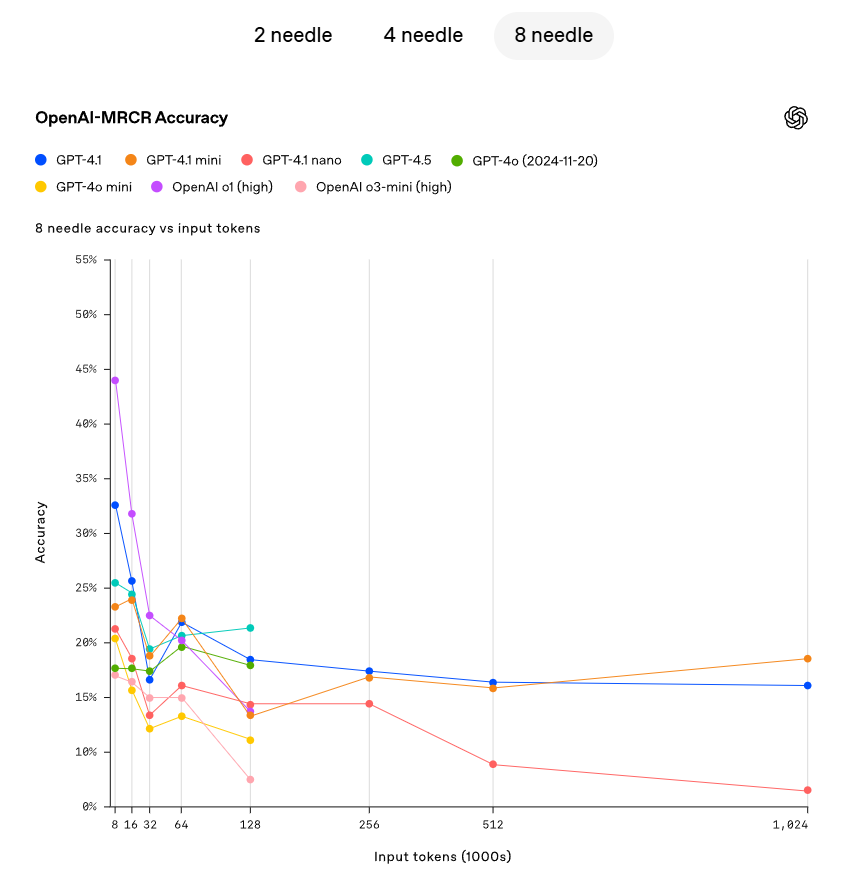

OpenAI展示了GPT-4.1檢索位於上下文窗口內各個點的隱藏小資訊(needle)的能力。GPT-4.1能夠持續準確地檢索所有位置和所有上下文長度的needle,最大檢索量可達100萬個token。無論這些token在輸入中的位置如何,GPT-4.1都能有效地提取與當前任務相關的細節。然而,現實世界中很少有任務像檢索一個顯而易見的「needle」答案那樣簡單。OpenAI發現用戶經常需要模型檢索和理解多條信息,並理解這些信息之間的相互關聯。為了展示這一能力,OpenAI開源了一項新的評估:OpenAI-MRCR(多輪共指)。OpenAI-MRCR測試模型識別並消除上下文中隱藏的多個「needle」的能力。評估包括用戶和助手之間的多輪合成對話,用戶要求助手撰寫一篇關於某個主題的文章,例如「寫一首關於貘的詩」或「寫一篇關於岩石的博客文章」,接著會在整個上下文中插入兩個、四個或八個相同的請求,最後模型必須檢索與特定實例對應的響應(例如「給我第三首關於貘的詩」)。挑戰在於這些請求與上下文其餘部分的相似性,模型很容易被細微的差異誤導,例如關於貘的短篇故事而不是詩歌,或者關於青蛙的詩歌而不是貘。OpenAI發現,GPT-4.1在上下文長度高達128K個token時的表現優於GPT-4o,並且即使長度高達100萬個token時也能保持強勁的性能。

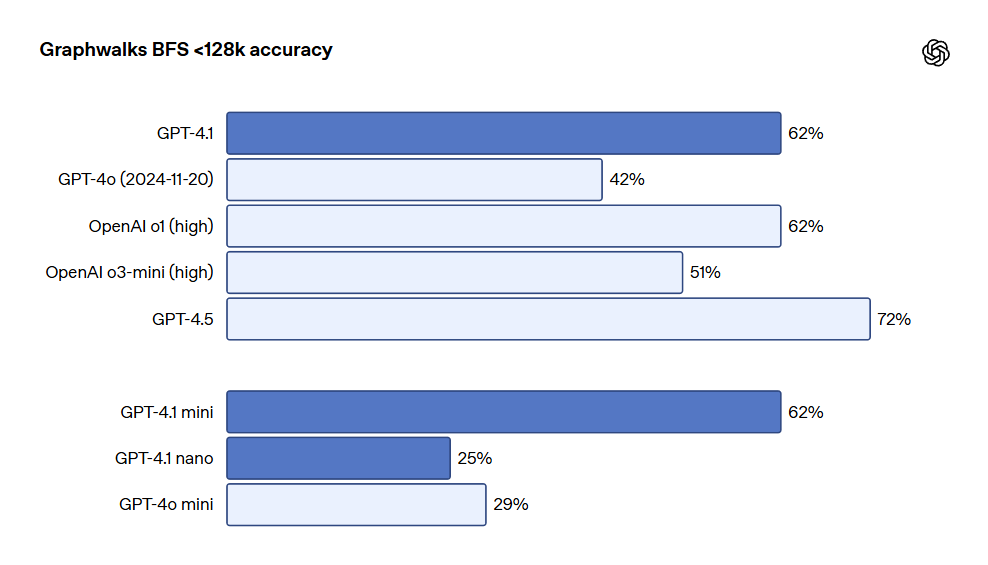

OpenAI還發布了Graphwalks,這是一個用於評估多跳長上下文推理的數據集。許多開發者在長上下文用例中需要在上下文中進行多次邏輯跳躍,例如在編寫代碼時在多個文件之間跳轉,或在回答複雜的法律問題時交叉引用文檔。理論上,模型(甚至人類)可以通過一遍遍閱讀提示詞來解決OpenAI-MRCR問題,但Graphwalks的設計要求在上下文中的多個位置進行推理,並且無法按順序求解。Graphwalks會用由十六進制哈希值組成的有向圖填充上下文窗口,然後要求模型從圖中的隨機節點開始執行廣度優先搜索(BFS)。然後要求它返回一定深度的所有節點。結果顯示,GPT-4.1在此基準測試中達到了61.7%的準確率,與GPT-4o的性能相當,並輕鬆擊敗了GPT-4o。

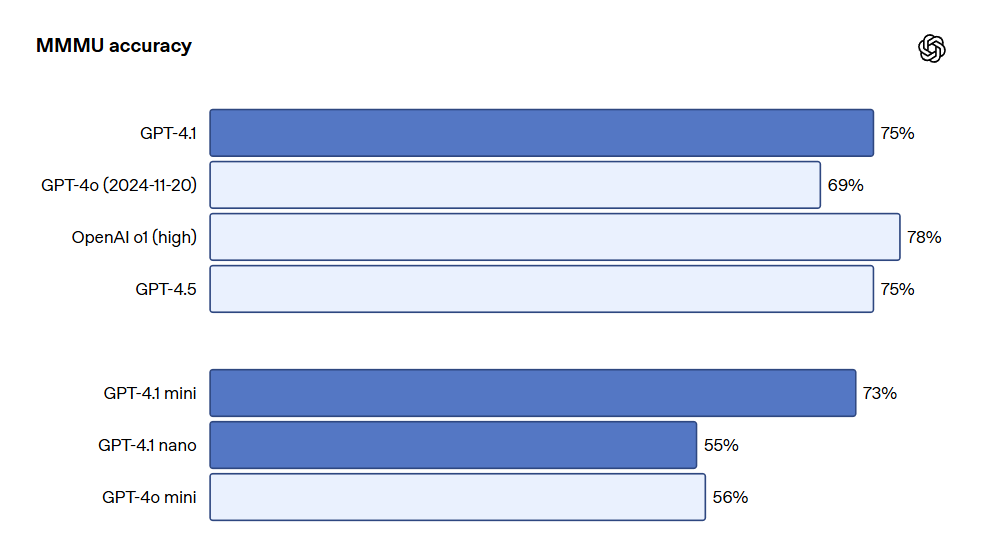

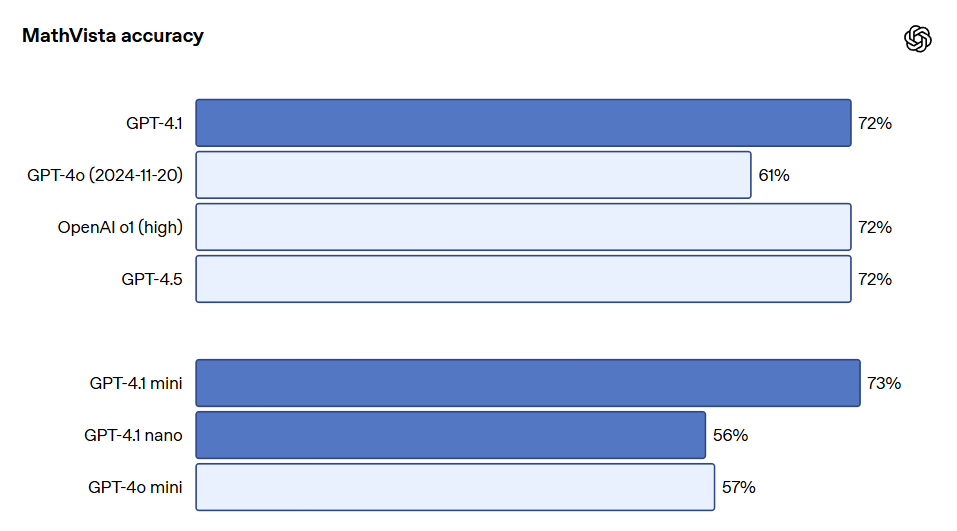

視覺GPT-4.1系列模型在圖像理解方面同樣非常強大,尤其是GPT-4.1 mini實現了重大的飛躍,在圖像基準測試中經常擊敗GPT-4o。以下為MMMU(回答包含圖表、圖解、地圖等的問題)、MathVista(解決視覺數學問題)、CharXiv-Reasoning(回答科學論文中關於圖表的問題)等基準上的表現對比。

長上下文性能對於多模態用例(例如處理長視頻)也至關重要。在Video-MME(長視頻無字幕)中,模型基於30-60分鐘長的無字幕視頻回答多項選擇題。GPT-4.1達到了最佳性能,得分為72.0%,高於GPT-4o的65.3%。

更多測試指標請參考OpenAI原博客。博客地址:https://openai.com/index/gpt-4-1/

我們的精彩評測

最佳 AI 圖片生成器:FLUX Kontext 讓圖片編輯變得輕鬆

FLUX Kontext 是一款強大的生成式流匹配模型,能簡化圖片編輯流程,支持去水印、風格轉換等多種功能。

最佳AI圖片生成器:FLUX.1 Kontext模型的革新與應用

FLUX.1 Kontext模型的發布標誌著AI圖像生成和編輯的一次重要突破,具備上下文感知的圖像生成能力及多種創新功能。

最佳AI圖片生成器:探索免費的Raphael AI和商湯的秒畫

這篇文章介紹了兩款全年免費的AI畫圖工具:Raphael AI和商湯的秒畫,幫助用戶生成高品質的圖片,無需額外費用。

OpenAI 最新 GPT-4.1 系列模型发布:最佳 AI 图像生成器与编程性能

OpenAI 推出三款新模型 GPT-4.1 系列,性能超越前作,并在多项基准测试中表现优异。