더 많은 AI 최신 기술 정보를 원하시면 저희를 주목해 주세요: 【closerAI ComfyUI】FLUX 에코시스템의 초속 출력 시대가 열렸습니다! 가장 강력한 가속기 nunchaku의 실제 성능: 초속 이미지를 생성하고, 메모리 사용량이 3배 감소했습니다! 생산성 도구로 거듭났습니다. 안녕하세요, 저는 Jimmy입니다. 이번 회차에서는 폭발적인 프로젝트인 FLUX 모델을 소개하겠습니다. FLUX 모델은 매우 많은 메모리를 소모하기 때문에, 8GB 그래픽카드를 사용하는 저로서는 1.5~2분 정도 소요되었습니다. 이는 LORA, fill, redux 및 기타 제어 방식을 적용하지 않은 경우입니다. 제어 방식을 추가하면 시간이 더 걸립니다. 생성을 위한 이미지 품질은 다른 모델에 비해 우수하지만, 생성 속도가 느린 것이 단점입니다. 여러 가속 솔루션이 있지만 teacha, sagettention 같은 이름은 생산성 도구로서의 효율성이 부족합니다. 이제 새로운 기술 방향인 4비트 확산 모델 추론 엔진 nunchaku가 등장했습니다. 최근에 0.2 버전이 출시되어 FLUX의 초속 출력을 달성했으며, 생기는 이미지 품질은 원본 모델과 거의 차이가 없습니다.

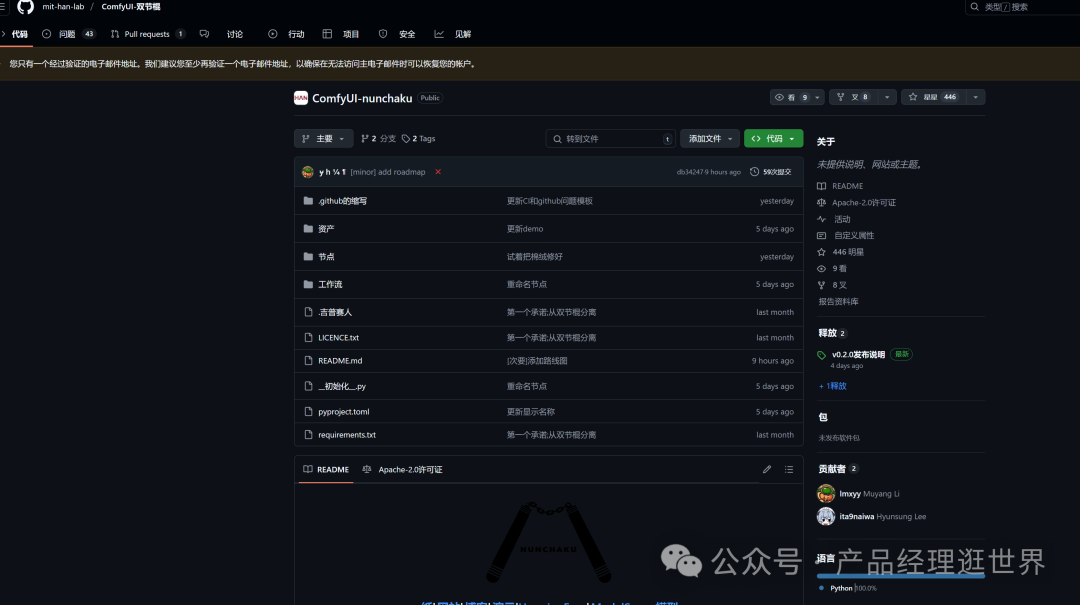

comfyUI-nunchaku 소개: nunchaku는 MIT Han Lab에서 개발한 4비트 확산 모델 추론 엔진으로 Stable Diffusion, Flux 등 생성 AI 모델을 최적화하기 위해 설계되었습니다. 핵심 기술의 돌파구로는 SVDQuant 양자화 기술이 있습니다. 저차원 분해(Singular Value Decomposition)와 커널 융합(Kernel Fusion)을 통해 모델 가중치와 활성화 값을 4비트로 압축하여 메모리 사용량을 3.6배 줄였습니다(예: 16GB 메모리로 원래 50GB 필요하던 Flux.1-dev 모델을 실행 가능). 전통적인 4비트 양자화의 이미지 흐릿함 문제를 해결하며, LPIPS 품질 지표는 단 0.326입니다(원본은 0.573에 가깝습니다). 육안으로는 차이가 없습니다. 다중 모달 에코시스템과 호환됩니다. Flux 모델, LoRA, ControlNet 및 다중 그래픽 카드 아키텍처(NVIDIA Ampere/Ada/A100)를 완벽하게 지원합니다. 문서 생성 및 ControlNet 재작업, 수리 등 속도가 8.7배 향상되었습니다. 하드웨어 수준에서 최적화되었습니다. NVIDIA CUDA 아키텍처를 대상으로 최적화되어 FP16/FP8 혼합 정밀도 계산을 지원하며, 16GB 그래픽카드로 3초 만에 생성할 수 있습니다(원본은 111초 소요됩니다).

comfyui 노드: https://github.com/mit-han-lab/ComfyUI-nunchaku

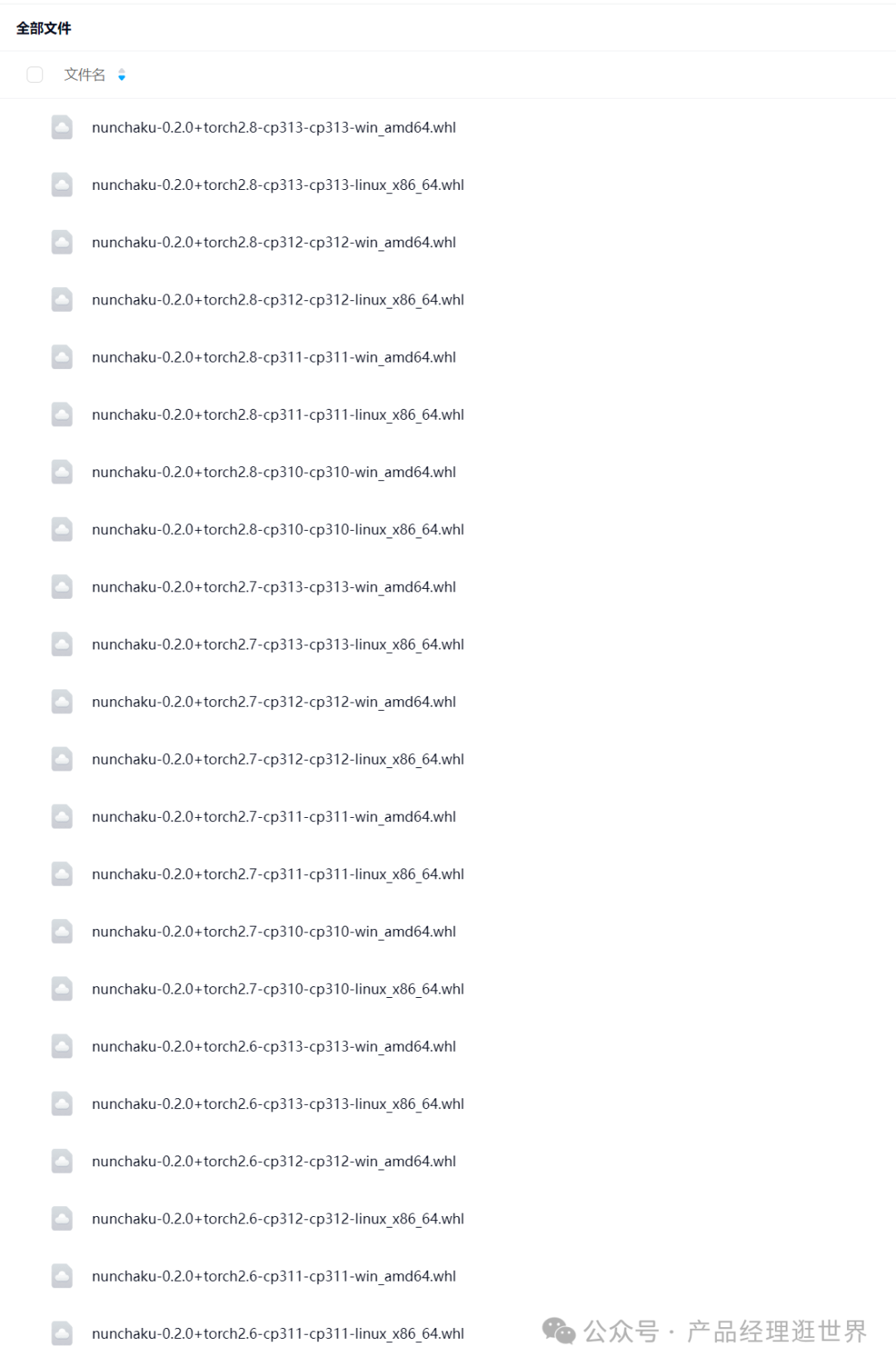

휠 주소: https://huggingface.co/mit-han-lab/nunchaku/tree/main

4월 5일 v0.2.0 버전이 출시되었습니다! 이 버전은 다중 LoRA와 ControlNet 지원을 추가하였고, FP 16 주의력 및 First-Block Cache를 통해 성능을 향상시켰습니다. FLUX.1-redux에는 20시리즈 GPU 호환성을 추가했습니다. 설치 방법: 1. 노드를 다운로드하여 comfyUI/custom_nodes에 배치합니다. 2. 휠을 설치합니다. 위의 주소에서 직접 PIP로 설치하세요. 반드시 PyTorch 2.5 이상 버전이 필요하며, 버전이 부족할 경우 업그레이드하시기 바랍니다. 미리 Python 패키지를 백업하는 것을 잊지 마세요. 휠 다운로드는 자신의 버전과 일치하는 것을 선택하세요.

3. 모델을 다운로드하여 comfyUI/models/unet에 배치합니다.

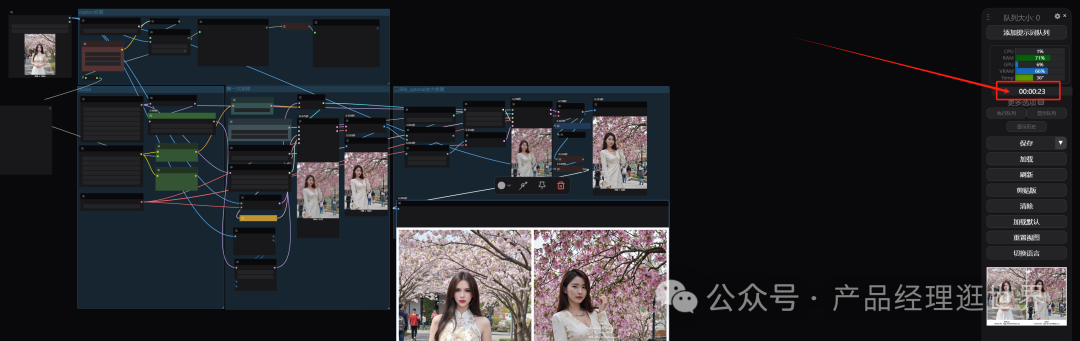

comfyUI 경험과 최적화 솔루션을 위해 재시작합니다. 이 노드 패키지에는 워크플로우가 포함되어 있지만, 이 워크플로우로 직접 생성하는 경우 이미지 품질이 불안정할 수 있습니다. 그로 인해 여전히 상대적으로 약간의 차이가 느껴질 수 있습니다. 또한 모델 로드에는 일정 시간이 필요하지만, 수용 가능한 시간 내에 이루어집니다. 모델을 로드한 후 카드를 뽑거나 매개 변수를 수정하면 이미지 생성 속도가 획기적으로 빨라집니다.

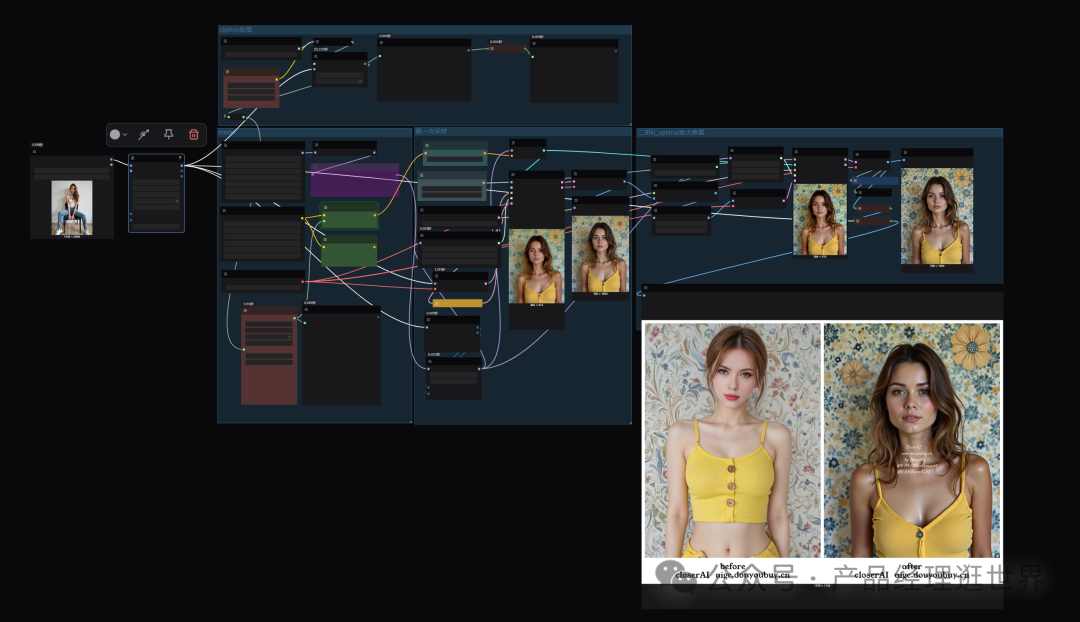

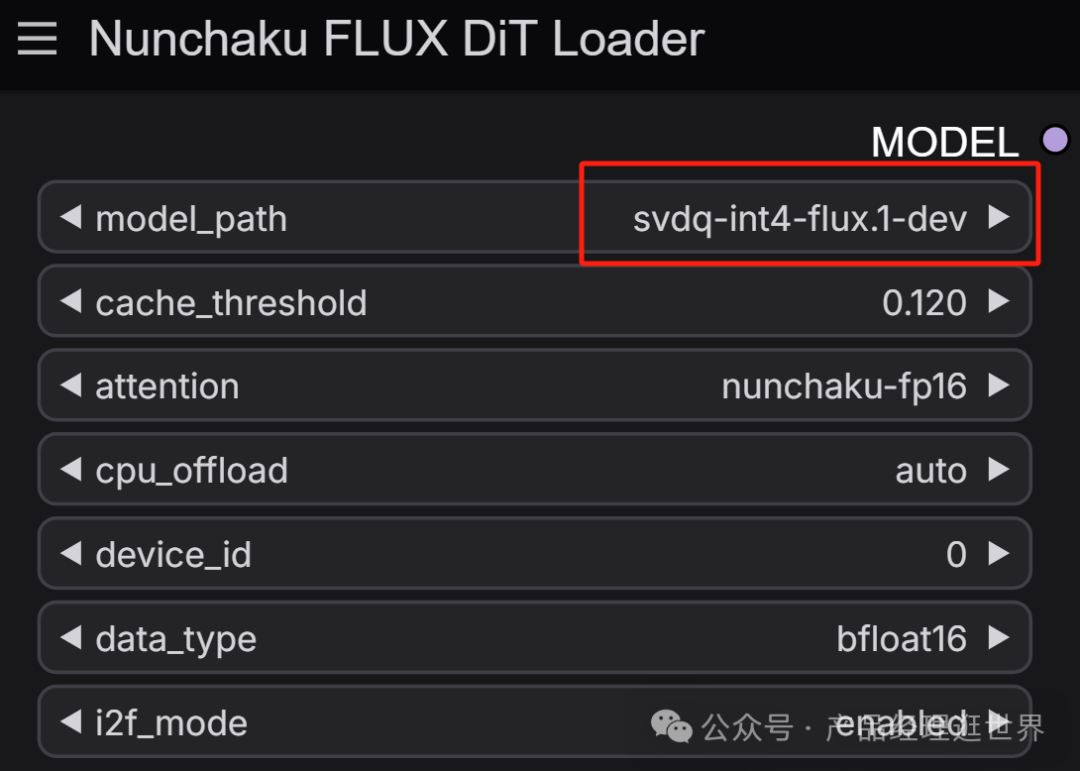

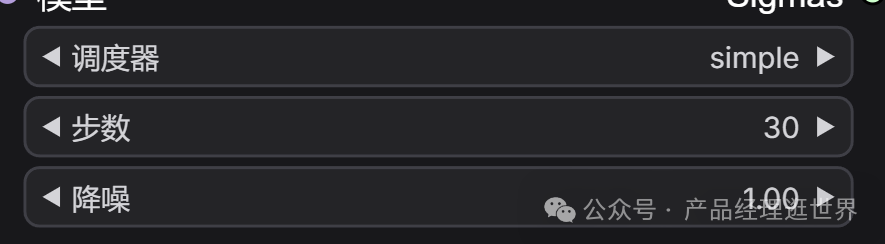

이상은 일부 확대 및 LORA 통합이 없는 이미지로, 원본 크기와 참고 스타일을 기반으로 생성된 것입니다. 저희 워크플로우 아이디어는 다음과 같습니다: 1. nunchaku FLUX 기반의 문서 생성 워크플로우를 첫 번째 샘플로 생성합니다. 여기에서는 SVDQ-int4-flux.1-dev 모델을 사용하며, 기타 참고 설정은 다음과 같습니다:

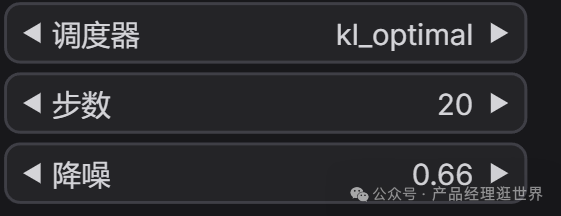

2. kl_optimal을 통해 두 번째 샘플 생성을 진행합니다.

로컬 성능이 부족한 경우, 온라인 comfyUI를 추천합니다.

runninghub.cn nunchaku FLUX 워크플로우 체험 주소: https://www.runninghub.cn/ai-detail/1910201953526448130

등록 주소: https://www.runninghub.cn/?utm_source=kol01-RH151

이 링크를 통해 가입 시 1000점을 즉시 지급하며, 매일 로그인시 100점을 지급합니다.

마지막 한마디: nunchaku FLUX의 장점은 초고속 이미지 생성으로 FLUX의 느린 속도의 단점을 해결했습니다. 또한 생태계도 점차 발전하여 FLUX의 fill, redux, controlnet, 다중 LoRA 등을 지원합니다. 일정 부분에서 FLUX를 대체하여 이미지 생성에 사용할 수 있습니다. 개인적으로 추천드립니다. 생산성을 위해 바닥 이미지를 생성하기에 충분합니다. 이번 글은 closerAI 팀이 제작한 stable diffusion comfyUI 및 closerAI가 개발한 FLUX nunchaku 슈퍼 가속 이미지 생성 워크플로우 소개입니다. 여러분은 이 워크플로우 아이디어에 따라 시도해 보실 수 있습니다. 물론 closerAI 회원 사이트를 통해 관련 워크플로우도 얻을 수 있습니다(원문 보기). 이상입니다. 이 글이 유익했다면, 좋아요와 공유를 눌러주세요. 저를 별표 ⭐로 추가하시면 최신 소식을 바로 받을 수 있습니다. 제 글을 읽어 주셔서 감사합니다. 다음에 또 만나요.

멋진 리뷰들

Best AI Image Generator: FLUX.1 Kontext 모델의 혁신과 성능

FLUX.1 Kontext 모델은 AI 이미지 생성과 편집의 혁신을 가져오는 새로운 세대의 모델입니다.

최고의 AI 이미지 생성기: Vidu Q1 동영상 생성 모델의 혁신적 발전

Vidu Q1은 텍스트 설명이나 이미지에 따라 고화질의 1080P 비디오를 자동으로 생성하는 최첨단 AI 비디오 생성 모델입니다.

최고의 AI 이미지 생성기: 무료로 고품질 이미지를 생성하는 두 가지 도구

이 글에서는 무료 AI 이미지 생성기인 Raphael AI와 상양의 초단기 그림에 대해 살펴봅니다.